Суперкомпьютер SuperMUC-NG

Иванов Д. Е.,

ВМК МГУ,

Москва, 2018

1 Введение

В декабре 2017 года Суперкомпьютерный центр Лейбница Баварской Академии Наук и Гуманитарных наук представил следующее поколение суперкомпьютера SuperMUC-NG.

Рисунок 1 . Суперкомпьютер SupeMUC-NG

Открытие планировалось на начало 2019 года, однако на данный момент компьютер уже работает в пользовательском режиме. Согласно некоторым источникам он был пущен в работу в сентябре 2018 года.

Финансирование SuperMUC-NG делится поровну между правительством Германии и Свободным Государством Бавария. Общая стоимость проекта 96 миллионов евро на шесть лет, включая электричество, поддержку и обслуживание [1].

2 Технические характеристики

Таблица 1. Технические характеристики системы.

|

Вычислительные узлы |

Тонкие узлы |

Толстые узлы |

Всего |

|

Процессоры |

Intel Xeon Platinum 8174 24C 3.1GHz |

||

|

Ядер на узел |

48 |

48 |

48 |

|

Память на узел (GByte) |

96 |

768 |

NA |

|

Число узлов |

6,336 |

144 |

6,480 |

|

Общее число ядер |

304,128 |

8,912 |

311,040 |

|

Суммарная пиковая производительность (PFlop/s) |

26.3 |

0.6 |

26.9 |

|

Linpack (Pflop/s) |

TBD[1] |

TBD |

19.476 |

|

Память (TByte) |

608 |

111 |

719 |

|

Файловые системы |

|||

|

Высокопроизводительная параллельная файловая система |

50 PB @ 500 GB/s |

||

|

Хранилище научных данных |

20 PB @ 70 GB/s |

||

|

Хранилище пользовательских данных |

256 TB @ HDD-Tier 6 GB/s / SSD-Tier 25 GB/s |

||

|

Инфраструктура |

|||

|

Охлаждение |

Прямое, теплой водой |

||

|

Использование выработанного тепла |

Используются поглощающие охладители. |

||

|

Программное обеспечение |

|||

|

Операционная система |

SUSE Linux Enterprise Server 12 SP3 |

||

|

Система управления задачами |

SLURM |

||

|

Распределенная файловая система |

IBM Spectrum Scale (GPFS) |

||

|

Окружение разработки |

Intel Parallel Studio XE |

||

|

Межпроцессная коммуникация |

Intel MPI, (OpenMPI). |

||

|

Облачные компоненты |

|||

|

Узлы с двуми Nvidia V100 GPUs |

32 |

||

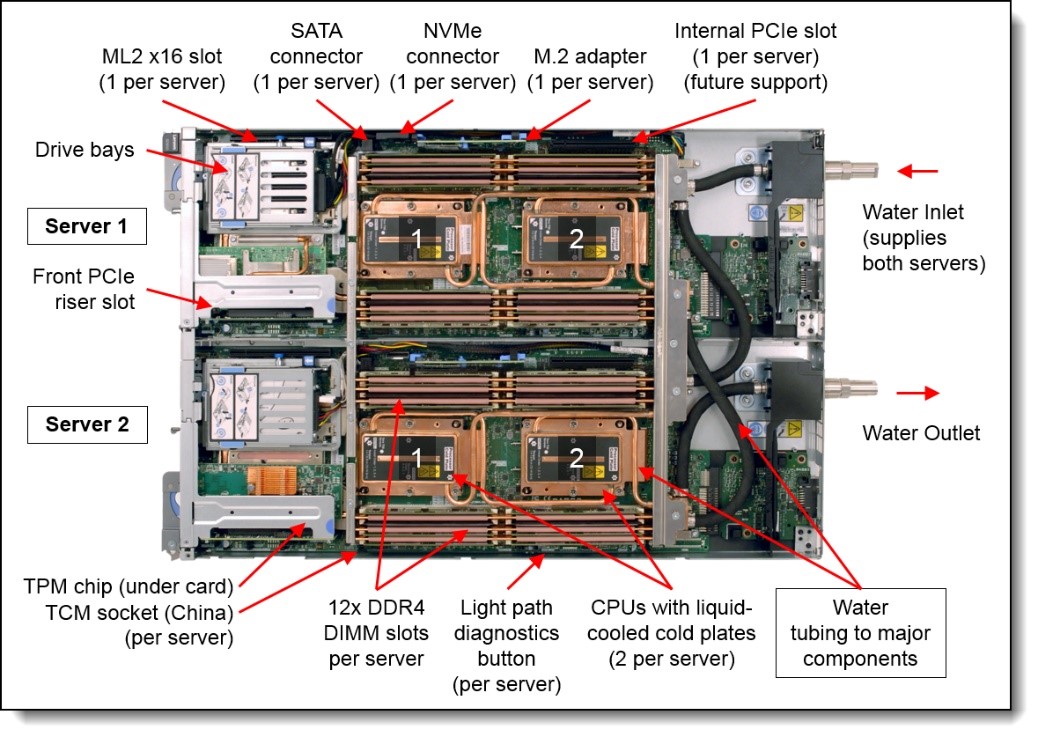

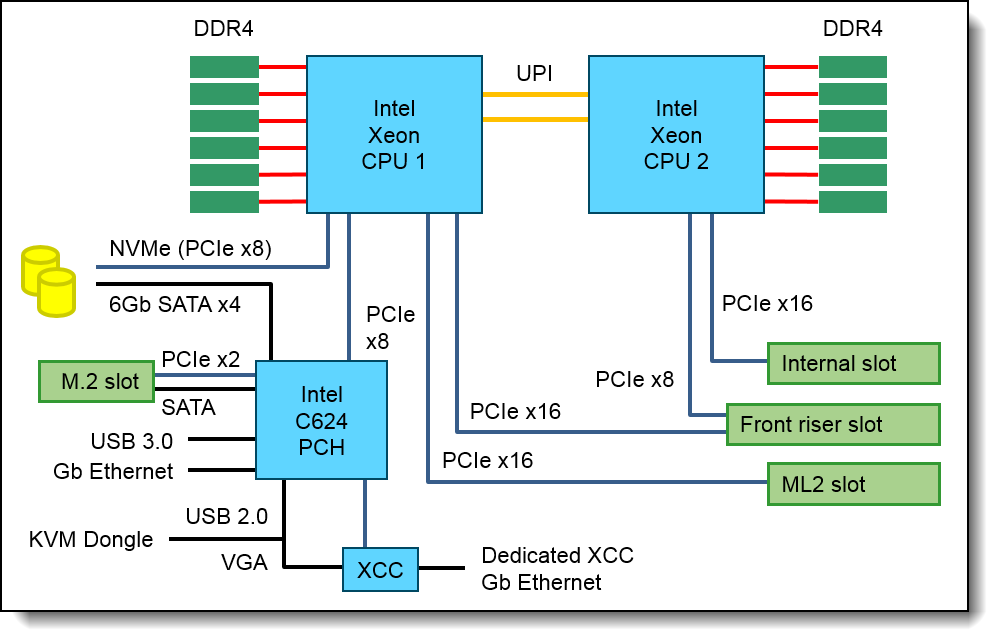

Система построена из 6480 вычислительных узлов Lenovo ThinkSystem SD650 DWC на базе процессоров Intel Xeon Scalable. Иллюстрацию устройства можно видеть на рисунках 2, 3. Технические подробности можно изучить на странице продукта [2].

Из них:

- 144 Толстых узла. На каждом 48 ядер и 768 ГБ памяти.

- 6446 Тонких узла. На каждом 48 ядер и 96 ГБ памяти.

Всего 311040 вычислительных ядер и 719 ТБ памяти. Теоретическая пиковая производительность составляет 26.7 PFLOP/s. На тесте Linpack система показала результат приблизительно 72% от пиковой производительности. На тесте HPCG производительность составила всего лишь 208 Терафлопс.

Дополнительно имеется 64 облачных узла, половина из которых снабжена двумя Nvidia V100 GPU. По заявлениям создателей, эти узлы нужны, чтобы соответствовать современным представлениям о работе с большими объемами данных и их визуализацией.

Рисунок 2. Внутренний вид двух модулей SD650 в ячейке с водяным охлаждением.

Рисунок 3. Функциональная блок-схема узла SD650

Блок-схема узла SD650 представлена на рис. 3. Согласно схеме, узел построен на чипсете Intel C624 PCH, а также снабжен большим количеством высокоскоростных слотов PCIe. Надо отметить, что пара процессоров Intel Xeon соединяются между собой посредством Intel Ultra Path Interconnect. Такое соединение обеспечивает пропускную способность до 10.5 GT/s. Для расширенного мониторинга системы и возможностей тонкой настройки поведения установлен чип XCC (XClarity Controller) от Lenovo.

Вычислительные узлы устанавливаются в корпус NeXtScale n1200 DWC, как показано на рис. 4.

Рисунок 4. Корпус NeXtScale n1200 DWC. Вид сзади.

Коммуникация между узлами производится по скоростной сети Intel OmniPath с заявленной пропускной способностью 100 Gbit/s.

Вычислительные узлы объединяются в 8 доменов (островов). Внутри каждого домена реализована коммуникационная топология Толстое дерево. Во избежание нежелательного трафика OmniPath между островами обрезана (pruned) со значением Prune-Factor равным 4.

3 Хранение данных

Под данные пользователей выделено 256 ТБ хранилища.

Для непродолжительного хранения больших файлов (до нескольких недель) предусмотрено 16 ПБ дискового пространства, работающего на скорости ~200 ГБ/c. Здесь предполагается хранить данные для возобновления расчета, либо промежуточные результаты обработки. Для продолжительного хранения (до окончания проекта) результатов расчета выделено 34 ПБ на скорости ~300 ГБ/с. Для хранения файлов проекта и загрузки информации извне выделено 20 ПБ хранилища, подключенного к высокоскоростному каналу связи, оптимизированному для передачи файлов. Загрузку можно производить через простой графический интерфейс пользователя [3].

4 Управление задачами

Для управления очередью задач и загрузкой используется менеджер нагрузки с открытым кодом SLURM (Simple Linux Utility for Resource Management [4]). Предусмотрены следующие классы пользовательских задач

Таблица 2. Классы задач, разрешенные на суперкьмпьютере SuperMUC-NG.

|

Класс задач |

Разрешенное число узлов |

Максимум доступной памяти |

Ядер на каждый узел |

Максимальное время работы ( часов ) |

Одновременно выполняющихся задач на пользователя |

|

Mixed (еще не доступен) |

64-3168 |

90 BG / 760 GB |

48 |

12 (будет увеличено) |

1 |

|

test |

1-16 |

90 GB |

48 |

0.5 |

1 |

|

micro |

1-16 |

90 GB |

48 |

48 |

20 |

|

general |

17-792 |

90 GB |

48 |

48 |

20 |

|

fat |

1-128 |

760 GB |

48 |

48 |

2 |

|

large |

793-3168 |

760 GB |

48 |

12 |

5 |

5 Энергоэффективность

Подобно своему предшественнику (SuperMUC) SuperMUC-NG охлаждается теплой водой. Lenovo разработали концепцию охлаждения, которая еще больше снизит потребление энергии, вместе с использованием генерируемой суперкомпьютером тепловой энергии для повторного охлаждения воды. О технологии можно прочитать подробнее в статье [5].

Заявляется, что кластеры SD650 DWC могут выдерживать температуру входной воды до 50 градус цельсия, при 85-95 процентной рекуперации тепла. На выходе из узла вода имеет температуру 58-60 градусов цельсия, в зависимости от нагрузки. Далее поглощающий охладитель уменьшает ее температуру до 20 градусов, приемлемых для охлаждения дискового массива и коммуникационной среды. Поглощенная энергия воды может быть использована для питания самого компьютера [1].

6 Список использованных источников

1 Eisenreich. S, «SuperMUC-NG: In the Service of Science», - «InSiDE» Innovative Supercomputing in Deutchland, - стр. 10-12, - Spring 2018,- Vol. 16, - No. 1

2 Watts D., ThinkSystem SD650 Direct Water Cooled Server Product Guide,- Электронный ресурс. URL: https://lenovopress.com/lp0636-thinksystem-sd650-direct-water-cooled-server/ ( дата обращения 20.12.18 )

3 SuperMUC-NG File Systems, - Электронный ресурс. URL: https://doku.lrz.de/display/PUBLIC/SuperMUC-NG+File+Systems ( дата обращения 20.12.18 )

4 Slurm Workload Manager, - Электронный ресурс. URL: https://slurm.schedmd.com/ ( дата обращения 20.12.18 )

5 Ott M., Kranzlmuller D. Best Practices in Energy-Efficient High Performance Computing, - Christian Czarnecki et al. (Hrsg.): Workshops der INFORMATIK 2018, Lecture Notes in Informatics (LNI), Gesellschaft für Informatik, Bonn 2018 167

[1] TBD (To Be Defined) - величина не была измерена на момент написания работы