Суперкомпьютер Lassen (IBM Power System S922LC)

Рязанов А. М.,

ВМК МГУ,

Москва, 2018

1. Введение

Суперкомпьютер с кодовым названием Lassen – один из нескольких суперкомпьютерных комплексов, расположенных на территории Ливерморской национальной лаборатории имени Э. Лоуренса (англ. LLNL, Lawrence Livermore National Laboratory), округ Аламида, штат Калифорния, США. Суперкомпьютер сконструирован с применением вычислительных технологий компаний IBM и NVIDIA. На данный момент он занимает 11-е место в рейтинге TOP500, и 237-е в рейтинге Green500 [1].

2. История

Суперкомпьютерный кластер Lassen был создан в середине 2017-го года, и впоследствии частично введён в эксплуатацию в ноябре 2018-го года в вычислительном центре Ливерморской национальной лаборатории. Создание кластера мотивировано потребностью в высокопроизводительной системе для применения в таких проектах, как: исследование средств борьбы с раком; точная медицина; исследование травм головного мозга; задачи сейсмологии, климатологии и астрофизики; научные исследования общего направления [2].

Рисунок 1. Суперкомпьютерный комплекс Sierra.

Проект суперкомпьютера Lassen был зарождён в 2014-м году, в ходе формирования передовой группы сотрудничества трёх крупнейших исследовательских институтов в области энергетики, CORAL (англ. Collaboration of Oak Ridge, Argonne, and Livermore). Основной задачей группы является установка современных суперкомпьютерных комплексов на замену устаревающим системам, одной из которых являлся суперкомпьютер Sequoia, расположенный в LLNL. Предложенный на замену суперкомпьютер Sierra имел производительность, превосходящую Sequoia в от 5 до 7 раз, с пиковой производительностью 120-150 петафлоп/c. Параллельно велась разработка суперкомпьютера uSierra (Unclassified Sierra), обладающего около 20-25% производительностью по сравнению с Sierra, который позднее был переименован в Lassen [3].

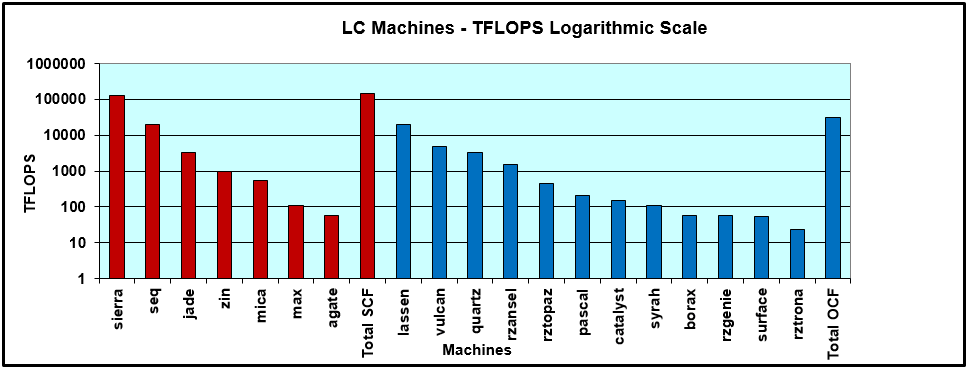

Рисунок 2. Сравнение производительностей суперкомпьютерных комплексов в составе LLNL.

Красные – зона SCF (Secure Computing Facility), кластеры с повышенным контролем доступа.

Синие – зона OCF (Open Computing Facility), кластеры общего назначения (несекретные исследования).

Кластер Lassen совместно с микрокластером RZAnsel, - ещё одним комплексом Sierra-подобных кластеров, состоящим из 54 узлов, - приходят на замену кластера Vulcan [4], использовавшегося для вычислений общего назначения, и имеющего истёкший срок службы по графику LLNL ступенчатого обновления суперкомпьютерного парка [5]. Производительность современного аналога в несколько раз превосходит производительность Vulcan (см. Рисунок 2). По архитектуре и внутреннему устройству, кластеры Lassen и RZAnsel идентичны, однако RZAnsel имеет самую низкую производительность среди Sierra-подобных комплексов, и предназначен исключительно под использование ограниченной группой допущенных исследователей. Lassen же будет использоваться на равных условиях сотрудниками как лаборатории, так и внешних заказчиков, будучи расположенным в зоне совместно-открытого доступа (OCF).

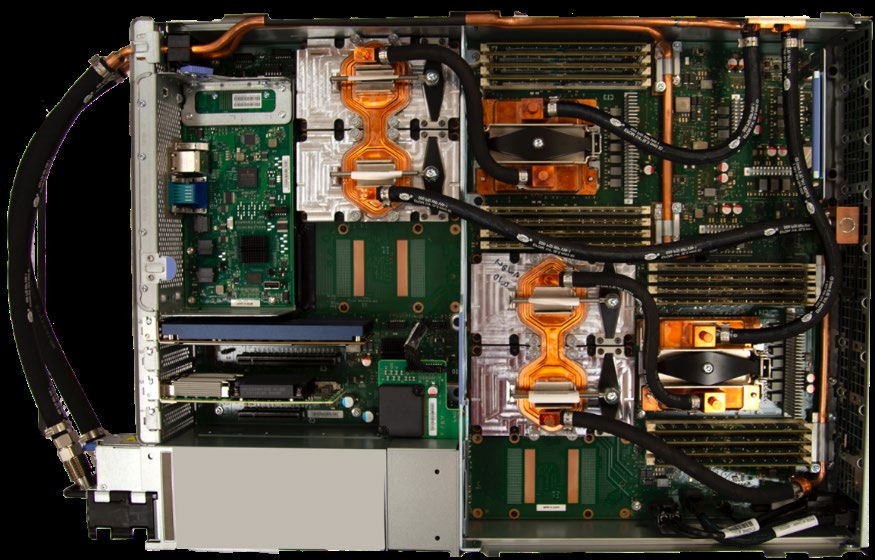

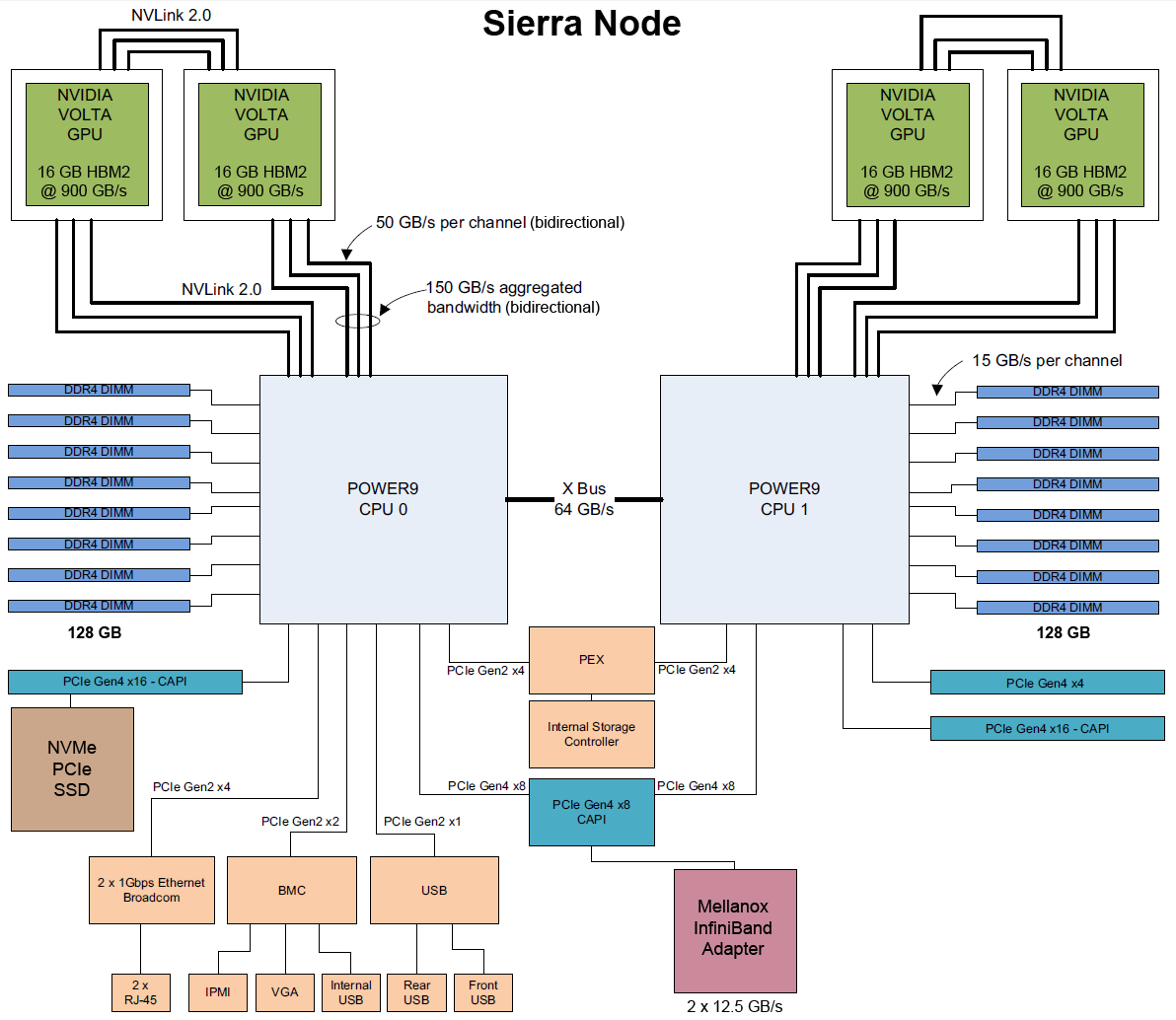

Вплоть до развёртывания систем Sierra, LNLL не использовала узлы с графическими ускорителями, за исключением микрокомплексов, предназначенных для визуализации [6]. Lassen использует графические ускорители современной архитектуры NVIDIA Volta вкупе с процессорами производства компании IBM на архитектуре POWER9, позволяющей эффективно использовать ресурсы графических ядер. Трёхкратное увеличение производительности достигается за счёт использования мультинаправленности интерфейса NVLink Gen2, позволяющего избежать накладных ограничений интерфейса PCIe 4.0. Сам интерфейс встроен в каждый из процессоров, что позволяет достигнуть суммарную пропускную способность до 150 ГБ/с в обе стороны между процессором и присоединённым к нему по NVLink графическим адаптером.

Суперкомпьютеры Sierra и Lassen потерпели значительные изменения с момента первичного формирования их конфигураций в связи с ростом цен на оперативную память в конце 2016-го года [6]. Изначально суперкомпьютерные узлы имели конфигурацию с 512 ГБ оперативной памяти и 6 графическими ускорителями NVIDIA Volta. Итоговая конфигурация отличается использованием модулей по 16 ГБ вместо 32. Суммарный объём оперативной памяти – 256 ГБ. Изменения также коснулись устройства сетевых интерфейсов узлов: вместо использования из двух доступных каналов InfiniBand по 100 Гбит/с, используется лишь один. По словам одного из инженеров проекта Sierra, это связано с устремлением финансирования на увеличение количества предустановленных GPU (с 3-х до 4-х), и что падение производительности от использования всего лишь одной полосы IB EDR в вычислениях с длительным исполнением редко превышает 1-2%.

Рисунок 3. Узел Sierra AC922 с 4-мя GPU NVIDIA Volta.

|

Кол-во вычислительных узлов |

684 |

|

Количество серверных стоек |

46 |

|

Вычислительные узлы |

38 (под кластер Lassen) |

|

Хранилища информации |

4 (дисковые массивы параллельной системы GPFS; твердотельные накопители NVMe |

|

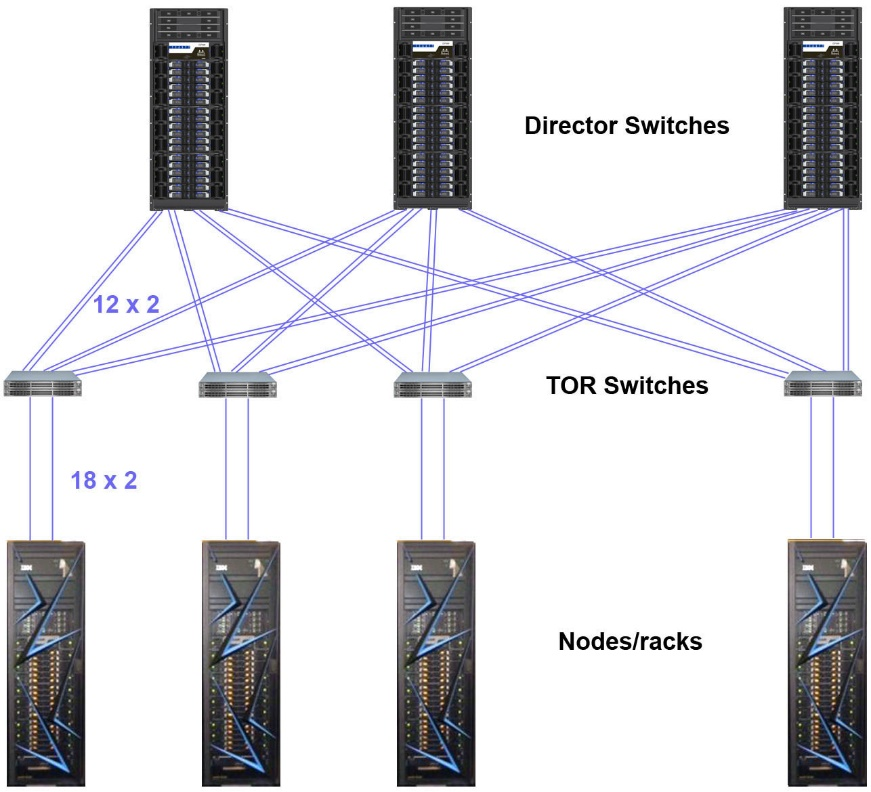

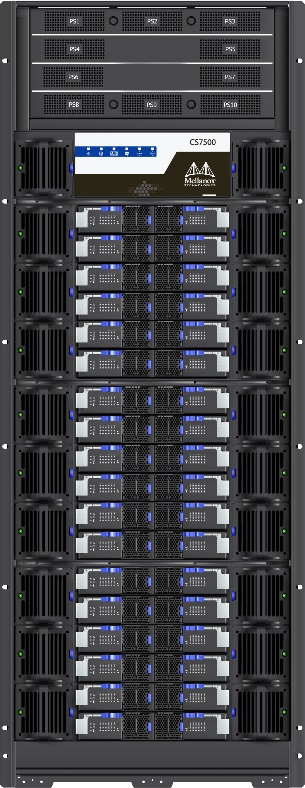

Сеть и коммутация |

4 (Mellanox CS7500, интерконнект Mellanox IB EDR) |

|

Система охлаждения |

«тёплое» водяное охлаждение |

|

Энергопотребление |

1,8 МВт (при полной нагрузке) |

3. Характеристики кластера

Рисунок 4. Топология сетевой инфраструктуры Sierra: 2:1 Tapered Fat Tree.

Рисунок 5. Коммутационная стойка Mellanox CS7500.

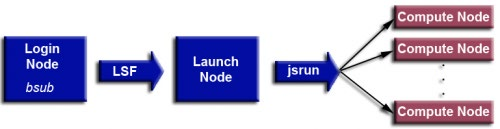

Рисунок 6. Принцип доступа к комплексу.

4. Характеристики узла

|

Платформа |

Сервер IBM Power Systems™ POWER AC922 (2U) |

|

Оперативная память (RAM) |

256 ГБ DDR4 (по 128 ГБ на CPU), модули по 16 ГБ |

|

Процессоры (CPU) |

2шт. IBM POWER9 22C SMT4 “Witherspoon”, 22C/22T @ 3,1 ГГц |

|

Графические адаптеры (GPU) |

4шт. NVIDIA Tesla V100 (только «compute/launch nodes»[1]) |

|

Память GPU (VRAM) |

16 ГБ HBM2, пропускная способность до 900 ГБ/с |

|

Форм-фактор |

модули SXM2 |

|

Вычислительные ядра |

CUDA, 5120 шт. (на адаптер) @ 1530 МГц |

|

Интерфейсы |

NVLink Gen2, пропускная способность до 150 ГБ/с (в обе стороны) |

|

Производительность |

7 ТФлоп/с (на адаптер) / 28,1 ТФлоп/с (общая) |

|

Постоянная память |

1,6 ТБ твердотельные накопители (SSD) NVMe PCIe производства Samsung (PM1725) и HGST (SN100) Операций ввода/вывода (IOPS): 1000K/120K [7] |

Рисунок 7. Схема устройства компонентов серверной платформы AC922 в конфигурации Sierra.

5.Программное обеспечение

|

Операционная система |

Red Hat Enterprise Linux 7.X |

||||

|

Планировщик задач |

IBM® Platform™ LSF® (внутрикластеровая ф.с.) |

||||

|

Файловая система |

IBM® Spectrum Scale™ |

||||

|

Доступные компиляторы |

Компилятор |

C |

C++ |

Fotran |

Примечания |

|

IBM XL |

+ |

+ |

+ |

Компилятор под архитектуру POWER9. |

|

|

IBM Clang |

+ |

+ |

|

LLVM-компилятор под архитектуру POWER9. |

|

|

GNU-комп. |

+ |

+ |

+ |

Стандартный компилятор *nix. |

|

|

PGI PGI C&T |

+ |

+ |

+ |

Компилятор с расширенной поддержкой OpenACC для взаимодействия с GPU NVIDIA. Функционирует в экспериментальном режиме. |

|

|

NVIDIA NVCC |

+ |

+ |

|

Использует другие компиляторы (по умолчанию GNU) |

|

|

Математические библиотеки |

Библиотека |

Расшифровка |

|||

|

ESSL |

IBM's Engineering Scientific Subroutine |

||||

|

MASS, MASSV |

IBM's Mathematical Acceleration Subsystem |

||||

|

BLAS, LAPACK, ScaLAPACK |

Пакеты для линейной алгебры Netlib |

||||

|

FFTW |

Библиотека Быстрого преобразования Фурье |

||||

|

PETSc |

“Portable, Extensible Toolkit for Scientific Computation library” |

||||

|

GSL |

GNU Scientific Library |

||||

|

CUDA Tools |

Мат.библиотеки NVIDIA CUDA Toolkit |

||||

|

Реализация MPI / OpenMP |

IBM Spectrum MPI (совместимая с Open MPI) |

||||

6.Список литературы

|

[1] |

TOP500.org, «Lassen - IBM Power System S922LC, IBM POWER9 22C 3.1GHz, Dual-rail Mellanox EDR Infiniband, NVIDIA Tesla V100» |

|

[2] |

LLNL, «Lawrence Livermore unveils NNSA’s Sierra, world’s third fastest supercomputer» |

|

[3] |

LLNL, «Compute Platforms: Lassen» |

|

[4] |

A. Bertsch, «Sierra ATS Update,» Ливермор, 2018. |

|

[5] |

LC System Administration, «LC Systems Update,» в LC User Meeting, Livermore, 2018. |

|

[6] |

T. P. Morgan, «The Clever Machinations of Livermore's Sierra Supercomputer» https://www.nextplatform.com/2017/10/05/clever-machinations-livermores-sierra-supercomputer/ |

|

[7] |

Samsung Electronics Company, «Samsung PM1275a NVMe SSD» https://hpc.llnl.gov/sites/default/files/SamsungPM1725aNVMeSSDbrochure.pdf |

|

[8] |

LLNL, «Using LC's Sierra Systems» https://hpc.llnl.gov/training/tutorials/using-lcs-sierra-system |

[1] В кластере применяется разделение на несколько типов машин: login nodes (узлы входа), launch nodes (узлы планировки и запуска задач), compute nodes (вычислительные узлы). В узлах типа «login nodes» не установлены GPU.